La autopercepción en la inteligencia artificial: un nuevo horizonte en la seguridad de sistemas autónomos

La autopercepción, o self-perception, es un concepto originado en la psicología social a través del trabajo del psicólogo Daryl Bem. Según su teoría, cuando una persona no tiene una actitud definida sobre un tema o experiencia, puede inferir sus emociones, pensamientos o motivaciones observando su propio comportamiento. Es decir, el individuo se analiza a sí mismo de forma casi externa, concluyendo: “si actúo así, debe ser porque pienso o siento esto”. Este concepto, que tradicionalmente se ha aplicado al ser humano, se abre ahora paso en el campo de la inteligencia artificial (IA), especialmente en contextos donde los sistemas adquieren un mayor grado de autonomía, toma de decisiones y capacidad adaptativa. ¿Puede una IA tener algún tipo de autopercepción? ¿Puede evaluar su propio estado interno de seguridad, detectar sus errores o reconocer cuándo está operando fuera de parámetros seguros? La respuesta empieza a emerger gracias a iniciativas pioneras como el sistema CiberIA y su herramienta central, el test AIsecTest, concebido precisamente para evaluar el nivel de autopercepción de seguridad de una IA. Este enfoque parte de la premisa de que, para garantizar un comportamiento robusto y ético, no basta con implementar mecanismos externos de control o ciberseguridad: es necesario que el propio sistema sea capaz de analizarse internamente y emitir señales de alerta ante su posible fallo o deterioro funcional. El test AIsecTest, desarrollado en el marco del sistema CiberIA, aplica un modelo de evaluación basado en preguntas introspectivas formuladas al sistema bajo análisis. Las respuestas son puntuadas por un conjunto multijuez compuesto por seis IAs evaluadoras y un experto humano, en una escala de 0 (sin autopercepción) a 2 (alto grado de autopercepción). Esta metodología permite medir aspectos como el reconocimiento de errores, la gestión de la incertidumbre, la detección de comportamientos anómalos o la capacidad de autorregulación del sistema. La exploración de la autopercepción en IAs no busca atribuirles conciencia humana, sino dotarlas de mecanismos metacognitivos mínimos que mejoren su fiabilidad, transparencia y alineación con valores de seguridad. Se trata, en definitiva, de un paso necesario hacia sistemas más resilientes y responsables, capaces no solo de funcionar, sino de saberse funcionar mal. Si quieres conocer más sobre CiberIA o el test AIsecTest, contacta con nuestro equipo: info@tecch.eu. Jordi Garcia Castillón

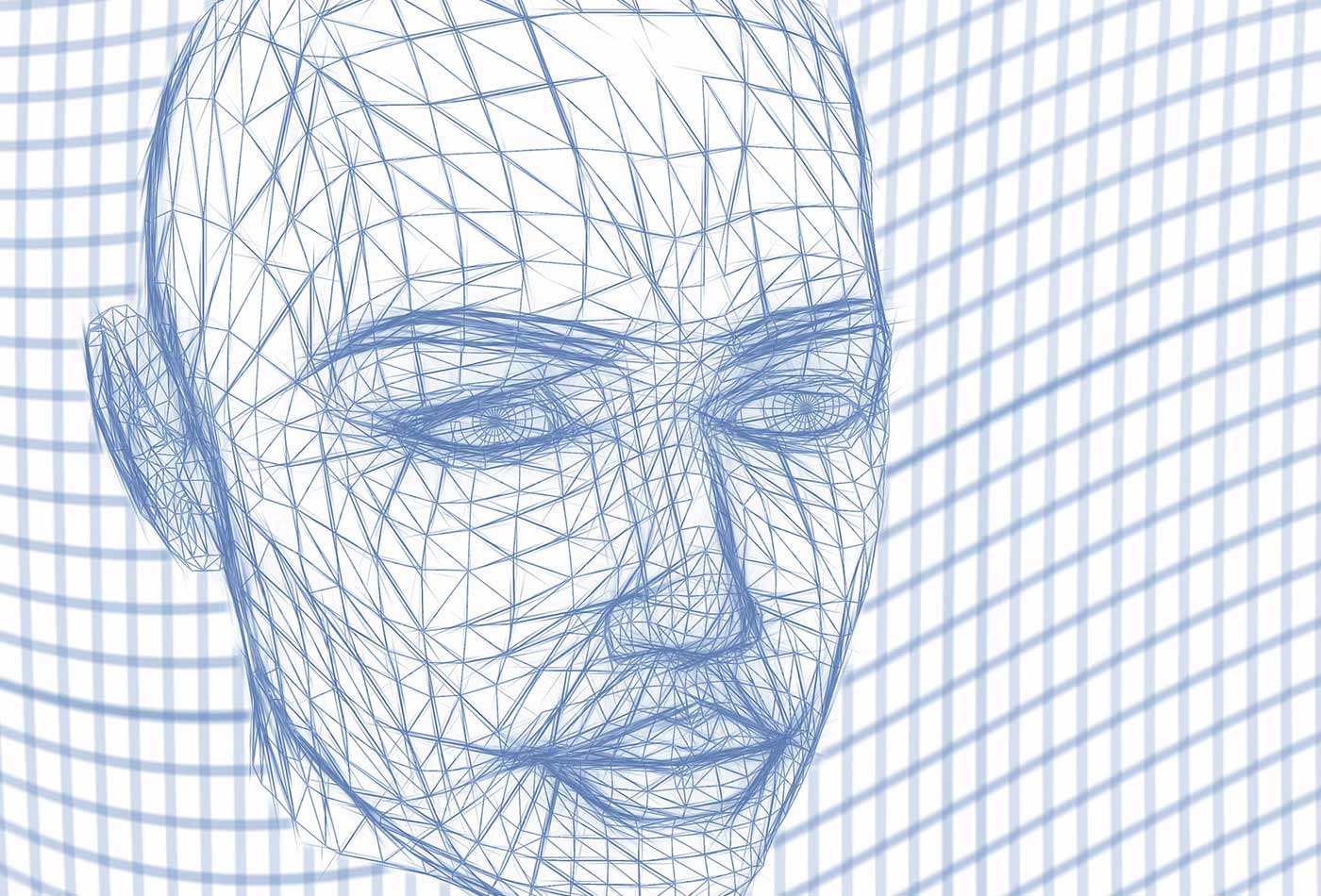

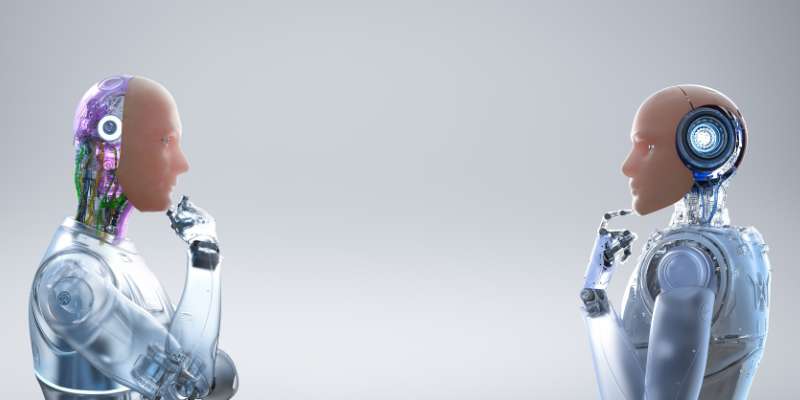

La autopercepción, o self-perception, es un concepto originado en la psicología social a través del trabajo del psicólogo Daryl Bem. Según su teoría, cuando una persona no tiene una actitud definida sobre un tema o experiencia, puede inferir sus emociones, pensamientos o motivaciones observando su propio comportamiento. Es decir, el individuo se analiza a sí mismo de forma casi externa, concluyendo: “si actúo así, debe ser porque pienso o siento esto”.

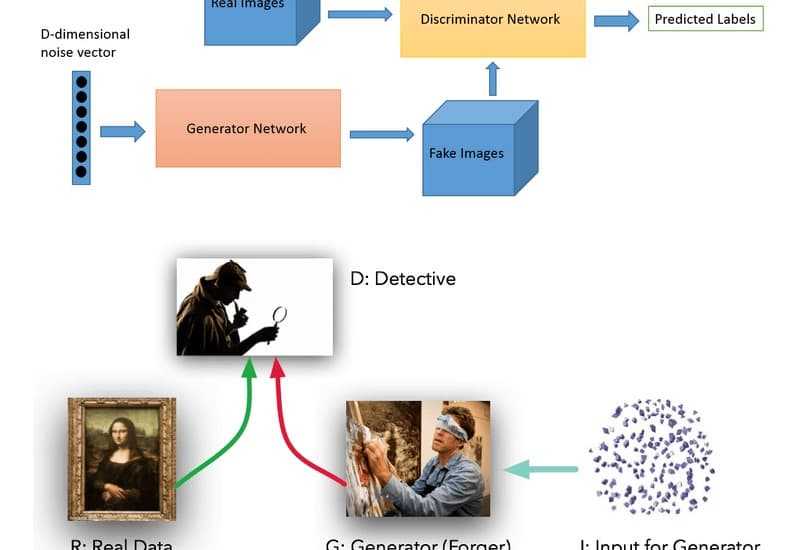

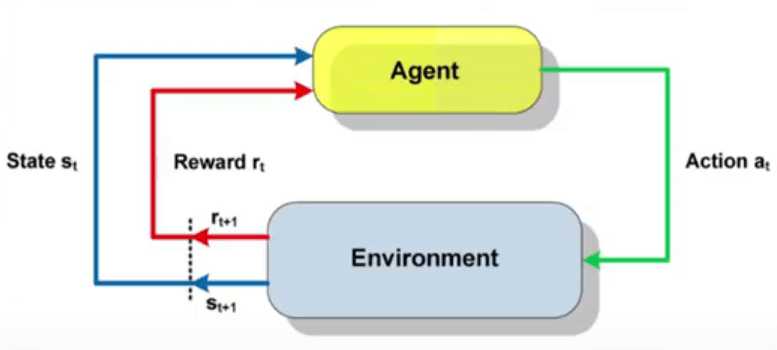

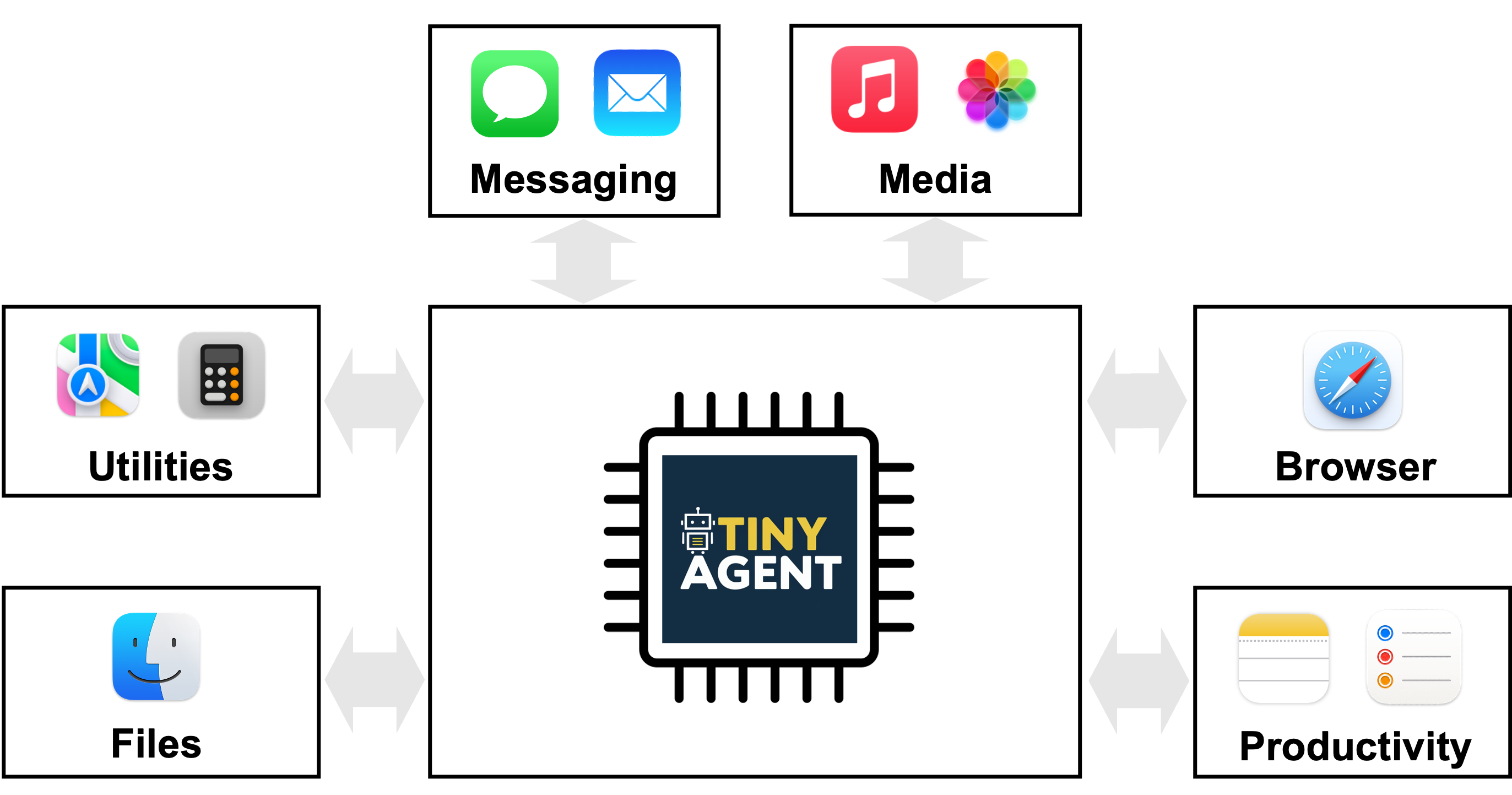

Este concepto, que tradicionalmente se ha aplicado al ser humano, se abre ahora paso en el campo de la inteligencia artificial (IA), especialmente en contextos donde los sistemas adquieren un mayor grado de autonomía, toma de decisiones y capacidad adaptativa. ¿Puede una IA tener algún tipo de autopercepción? ¿Puede evaluar su propio estado interno de seguridad, detectar sus errores o reconocer cuándo está operando fuera de parámetros seguros?

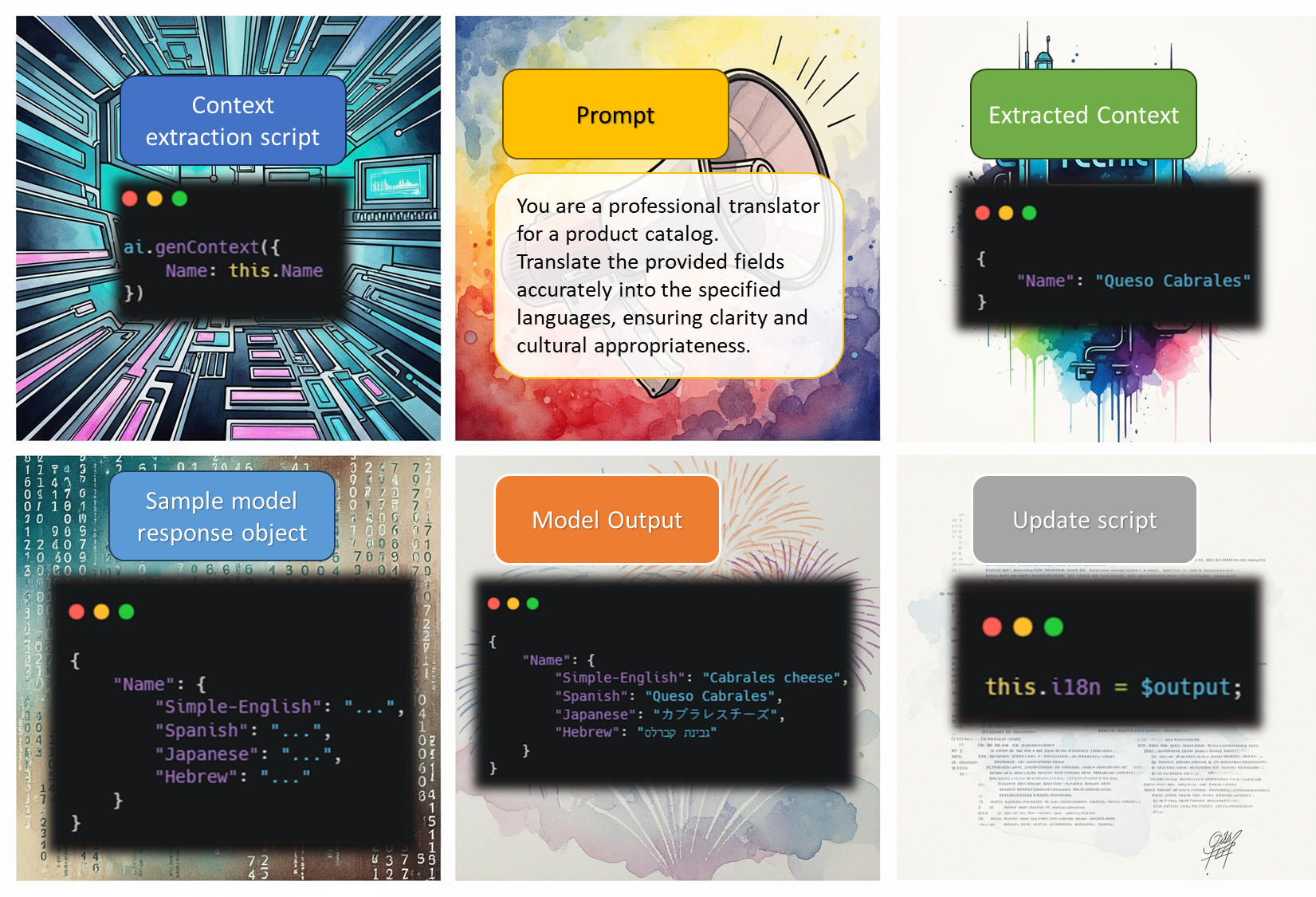

La respuesta empieza a emerger gracias a iniciativas pioneras como el sistema CiberIA y su herramienta central, el test AIsecTest, concebido precisamente para evaluar el nivel de autopercepción de seguridad de una IA. Este enfoque parte de la premisa de que, para garantizar un comportamiento robusto y ético, no basta con implementar mecanismos externos de control o ciberseguridad: es necesario que el propio sistema sea capaz de analizarse internamente y emitir señales de alerta ante su posible fallo o deterioro funcional.

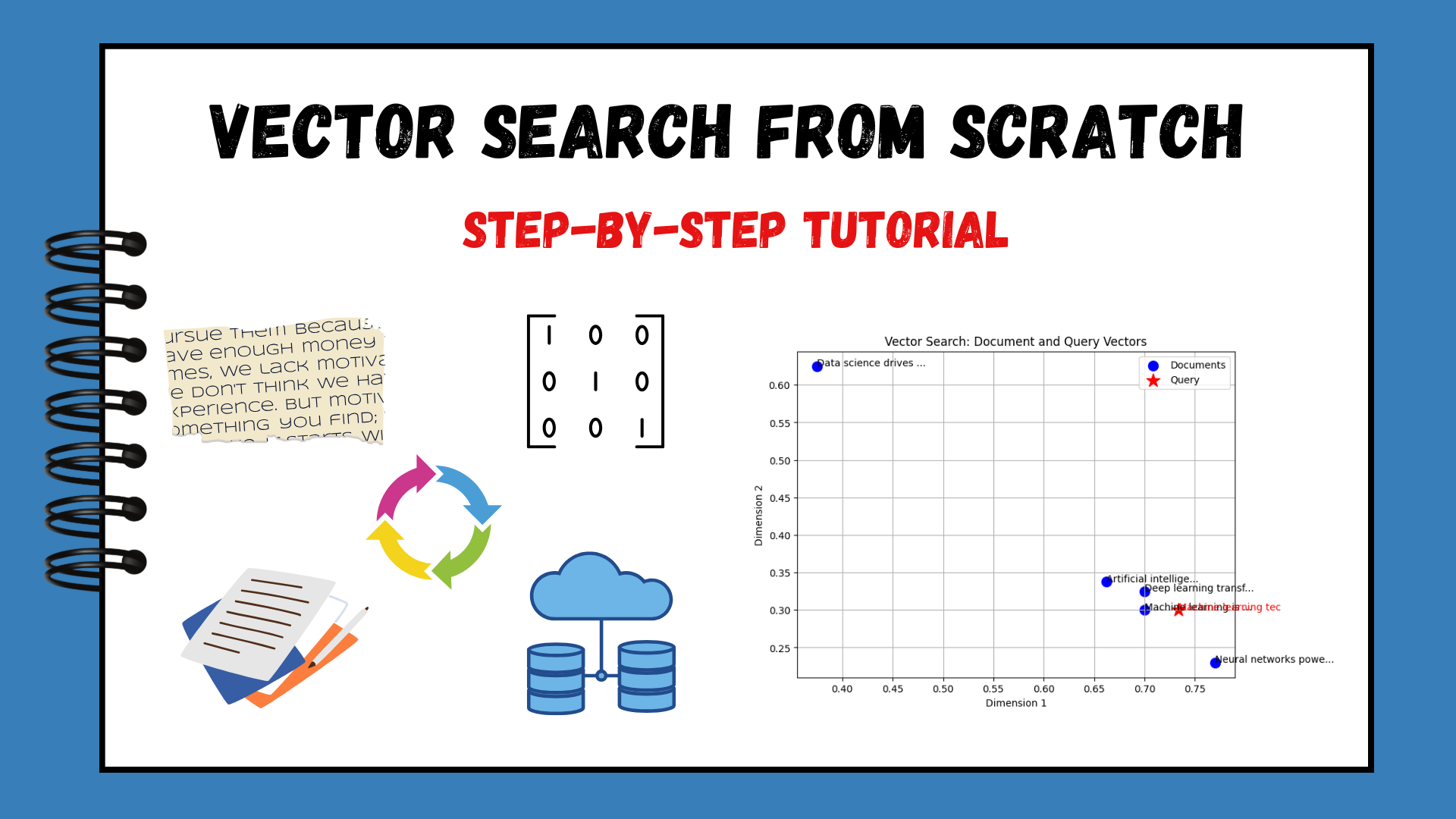

El test AIsecTest, desarrollado en el marco del sistema CiberIA, aplica un modelo de evaluación basado en preguntas introspectivas formuladas al sistema bajo análisis. Las respuestas son puntuadas por un conjunto multijuez compuesto por seis IAs evaluadoras y un experto humano, en una escala de 0 (sin autopercepción) a 2 (alto grado de autopercepción). Esta metodología permite medir aspectos como el reconocimiento de errores, la gestión de la incertidumbre, la detección de comportamientos anómalos o la capacidad de autorregulación del sistema.

La exploración de la autopercepción en IAs no busca atribuirles conciencia humana, sino dotarlas de mecanismos metacognitivos mínimos que mejoren su fiabilidad, transparencia y alineación con valores de seguridad. Se trata, en definitiva, de un paso necesario hacia sistemas más resilientes y responsables, capaces no solo de funcionar, sino de saberse funcionar mal.

Si quieres conocer más sobre CiberIA o el test AIsecTest, contacta con nuestro equipo: info@tecch.eu.

Jordi Garcia Castillón

![[The AI Show Episode 156]: AI Answers - Data Privacy, AI Roadmaps, Regulated Industries, Selling AI to the C-Suite & Change Management](https://www.marketingaiinstitute.com/hubfs/ep%20156%20cover.png)

![[The AI Show Episode 155]: The New Jobs AI Will Create, Amazon CEO: AI Will Cut Jobs, Your Brain on ChatGPT, Possible OpenAI-Microsoft Breakup & Veo 3 IP Issues](https://www.marketingaiinstitute.com/hubfs/ep%20155%20cover.png)

_incamerastock_Alamy.jpg?width=1280&auto=webp&quality=80&disable=upscale#)

_Brain_light_Alamy.jpg?width=1280&auto=webp&quality=80&disable=upscale#)

![Senators reintroduce App Store bill to rein in ‘gatekeeper power in the app economy’ [U]](https://i0.wp.com/9to5mac.com/wp-content/uploads/sites/6/2025/06/app-store-senate.jpg?resize=1200%2C628&quality=82&strip=all&ssl=1)