Java para Análise de Dados: Criando um Analisador de Dados com Apache Spark que Compete com Python

Repositório Java para Análise de Dados: A Alternativa Poderosa ao Python Quando falamos em análise de dados, Python é quase sempre a primeira linguagem que vem à mente. Mas e se eu dissesse que Java pode ser uma alternativa igualmente poderosa (e em alguns casos superior) para processar, analisar e visualizar dados? Neste artigo, vou compartilhar minha experiência criando um aplicativo de análise de dados em Java usando Apache Spark que vai direto de encontro às soluções em Python. Por que Java para Análise de Dados? Antes de mostrar o código, vamos entender por que considerar Java: Desempenho - Java é significativamente mais rápido que Python para operações computacionais intensivas Tipagem estática - Reduz drasticamente erros que só seriam descobertos em tempo de execução Multithreading robusto - Suporte nativo e maduro para programação concorrente Ecossistema maduro - Bibliotecas estáveis e bem testadas Integração empresarial - Melhor compatibilidade com sistemas corporativos existentes Claro, Python tem suas vantagens em termos de simplicidade e bibliotecas específicas para ciência de dados, mas Java merece uma segunda olhada, especialmente no contexto de grandes volumes de dados. O Projeto: Java Spark Data Analyzer O Java Spark Data Analyzer é um MVP que implementa uma interface interativa para analisar dados usando Apache Spark. Ele permite: Carregar dados de arquivos CSV Visualizar estatísticas e estruturas de dados Aplicar filtros e transformações Agregar dados para análises Exportar resultados em vários formatos O aplicativo tem uma interface de linha de comando simples, mas completa, que guia o usuário pelas diversas funcionalidades. Estrutura do Projeto A estrutura é bem simples: java-spark-data-analyzer/ ├── src/ │ └── main/ │ ├── java/ │ │ └── com/ │ │ └── dataanalyzer/ │ │ └── DataAnalyzer.java │ └── resources/ │ └── dados_vendas.csv ├── pom.xml └── README.md Optei por manter tudo em um único arquivo Java para este MVP, mas em uma aplicação de produção, seria recomendável modularizar mais o código. Implementação A classe principal DataAnalyzer implementa toda a lógica do aplicativo. Vamos analisar algumas partes importantes do código: Inicialização da Sessão Spark public void initialize() { // Configuração para evitar problemas no Windows System.setProperty("java.security.auth.login.config", ""); System.setProperty("hadoop.home.dir", new File("").getAbsolutePath()); // Configuração da sessão Spark spark = SparkSession.builder() .appName("Java Data Analyzer") .master("local[*]") // Usa todos os cores disponíveis localmente .config("spark.sql.warehouse.dir", "spark-warehouse") .config("spark.ui.enabled", "false") // Desativa a UI do Spark .config("spark.driver.host", "localhost") // Define host como localhost .getOrCreate(); // Define o nível de log para reduzir a verbosidade spark.sparkContext().setLogLevel("ERROR"); System.out.println("Spark inicializado com sucesso!"); System.out.println("Versão: " + spark.version()); } Carregamento de Dados CSV private void loadData(Scanner scanner) { System.out.print("Digite o caminho para o arquivo CSV (ou 'example' para usar o arquivo de exemplo): "); String path = scanner.nextLine(); if (path.equalsIgnoreCase("example")) { // Carrega o arquivo de exemplo da pasta resources path = "src/main/resources/dados_vendas.csv"; System.out.println("Usando o arquivo de exemplo: " + path); } File file = new File(path); if (!file.exists()) { System.out.println("Arquivo não encontrado: " + path); return; } System.out.print("O arquivo tem cabeçalho? (s/n): "); boolean hasHeader = scanner.nextLine().toLowerCase().startsWith("s"); System.out.print("Delimitador (padrão ','): "); String delimiter = scanner.nextLine(); if (delimiter.isEmpty()) { delimiter = ","; } try { // Carrega o CSV com as opções especificadas dataFrame = spark.read() .option("header", hasHeader) .option("delimiter", delimiter) .option("inferSchema", "true") .csv(path); System.out.println("Dados carregados com sucesso!"); System.out.println("Número de linhas: " + dataFrame.count()); System.out.println("Número de colunas: " + dataFrame.columns().length); } catch (Exception e) { System.out.println("Erro ao carregar os dados: " + e.getMessage()); } } Implementação de Filtros Uma das funcionalidades mais úteis é a capacidade de filtrar dados com base em condições específicas: private void filterData(Scanner scanner) { if (!checkDataFrameLoaded()) return; System.out.print

Java para Análise de Dados: A Alternativa Poderosa ao Python

Quando falamos em análise de dados, Python é quase sempre a primeira linguagem que vem à mente.

Mas e se eu dissesse que Java pode ser uma alternativa igualmente poderosa (e em alguns casos superior) para processar, analisar e visualizar dados? Neste artigo, vou compartilhar minha experiência criando um aplicativo de análise de dados em Java usando Apache Spark que vai direto de encontro às soluções em Python.

Por que Java para Análise de Dados?

Antes de mostrar o código, vamos entender por que considerar Java:

- Desempenho - Java é significativamente mais rápido que Python para operações computacionais intensivas

- Tipagem estática - Reduz drasticamente erros que só seriam descobertos em tempo de execução

- Multithreading robusto - Suporte nativo e maduro para programação concorrente

- Ecossistema maduro - Bibliotecas estáveis e bem testadas

- Integração empresarial - Melhor compatibilidade com sistemas corporativos existentes

Claro, Python tem suas vantagens em termos de simplicidade e bibliotecas específicas para ciência de dados, mas Java merece uma segunda olhada, especialmente no contexto de grandes volumes de dados.

O Projeto: Java Spark Data Analyzer

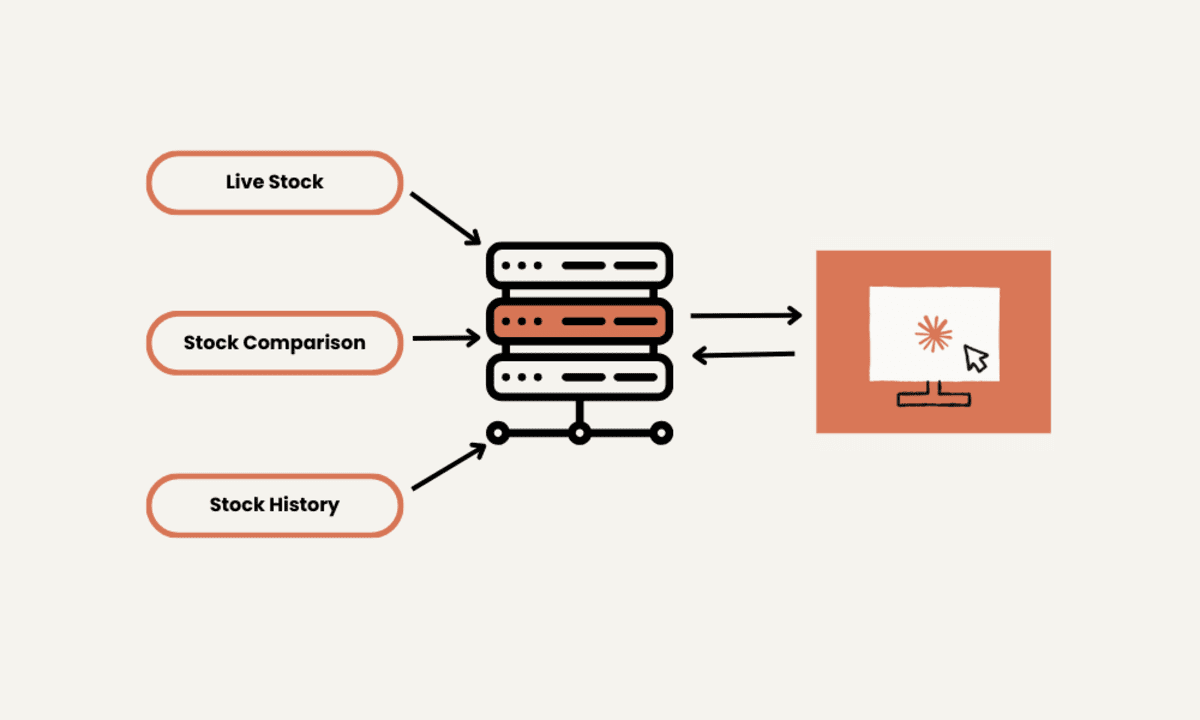

O Java Spark Data Analyzer é um MVP que implementa uma interface interativa para analisar dados usando Apache Spark. Ele permite:

- Carregar dados de arquivos CSV

- Visualizar estatísticas e estruturas de dados

- Aplicar filtros e transformações

- Agregar dados para análises

- Exportar resultados em vários formatos

O aplicativo tem uma interface de linha de comando simples, mas completa, que guia o usuário pelas diversas funcionalidades.

Estrutura do Projeto

A estrutura é bem simples:

java-spark-data-analyzer/

├── src/

│ └── main/

│ ├── java/

│ │ └── com/

│ │ └── dataanalyzer/

│ │ └── DataAnalyzer.java

│ └── resources/

│ └── dados_vendas.csv

├── pom.xml

└── README.md

Optei por manter tudo em um único arquivo Java para este MVP, mas em uma aplicação de produção, seria recomendável modularizar mais o código.

Implementação

A classe principal DataAnalyzer implementa toda a lógica do aplicativo. Vamos analisar algumas partes importantes do código:

Inicialização da Sessão Spark

public void initialize() {

// Configuração para evitar problemas no Windows

System.setProperty("java.security.auth.login.config", "");

System.setProperty("hadoop.home.dir", new File("").getAbsolutePath());

// Configuração da sessão Spark

spark = SparkSession.builder()

.appName("Java Data Analyzer")

.master("local[*]") // Usa todos os cores disponíveis localmente

.config("spark.sql.warehouse.dir", "spark-warehouse")

.config("spark.ui.enabled", "false") // Desativa a UI do Spark

.config("spark.driver.host", "localhost") // Define host como localhost

.getOrCreate();

// Define o nível de log para reduzir a verbosidade

spark.sparkContext().setLogLevel("ERROR");

System.out.println("Spark inicializado com sucesso!");

System.out.println("Versão: " + spark.version());

}

Carregamento de Dados CSV

private void loadData(Scanner scanner) {

System.out.print("Digite o caminho para o arquivo CSV (ou 'example' para usar o arquivo de exemplo): ");

String path = scanner.nextLine();

if (path.equalsIgnoreCase("example")) {

// Carrega o arquivo de exemplo da pasta resources

path = "src/main/resources/dados_vendas.csv";

System.out.println("Usando o arquivo de exemplo: " + path);

}

File file = new File(path);

if (!file.exists()) {

System.out.println("Arquivo não encontrado: " + path);

return;

}

System.out.print("O arquivo tem cabeçalho? (s/n): ");

boolean hasHeader = scanner.nextLine().toLowerCase().startsWith("s");

System.out.print("Delimitador (padrão ','): ");

String delimiter = scanner.nextLine();

if (delimiter.isEmpty()) {

delimiter = ",";

}

try {

// Carrega o CSV com as opções especificadas

dataFrame = spark.read()

.option("header", hasHeader)

.option("delimiter", delimiter)

.option("inferSchema", "true")

.csv(path);

System.out.println("Dados carregados com sucesso!");

System.out.println("Número de linhas: " + dataFrame.count());

System.out.println("Número de colunas: " + dataFrame.columns().length);

} catch (Exception e) {

System.out.println("Erro ao carregar os dados: " + e.getMessage());

}

}

Implementação de Filtros

Uma das funcionalidades mais úteis é a capacidade de filtrar dados com base em condições específicas:

private void filterData(Scanner scanner) {

if (!checkDataFrameLoaded()) return;

System.out.println("Colunas disponíveis: " + String.join(", ", dataFrame.columns()));

System.out.print("Digite o nome da coluna para filtrar: ");

String column = scanner.nextLine();

if (!Arrays.asList(dataFrame.columns()).contains(column)) {

System.out.println("Coluna não encontrada!");

return;

}

System.out.print("Digite o operador (=, >, <, >=, <=, !=): ");

String operator = scanner.nextLine();

System.out.print("Digite o valor: ");

String value = scanner.nextLine();

try {

// Aplica o filtro baseado no operador

switch (operator) {

case "=":

dataFrame = dataFrame.filter(col(column).equalTo(value));

break;

case ">":

dataFrame = dataFrame.filter(col(column).gt(value));

break;

case "<":

dataFrame = dataFrame.filter(col(column).lt(value));

break;

case ">=":

dataFrame = dataFrame.filter(col(column).geq(value));

break;

case "<=":

dataFrame = dataFrame.filter(col(column).leq(value));

break;

case "!=":

dataFrame = dataFrame.filter(col(column).notEqual(value));

break;

default:

System.out.println("Operador inválido!");

return;

}

System.out.println("Filtro aplicado! Número de linhas após filtro: " + dataFrame.count());

} catch (Exception e) {

System.out.println("Erro ao aplicar filtro: " + e.getMessage());

}

}

Agregações de Dados

Uma das principais vantagens do Spark é a facilidade para realizar agregações em grandes volumes de dados:

private void aggregateData(Scanner scanner) {

if (!checkDataFrameLoaded()) return;

System.out.println("Colunas disponíveis: " + String.join(", ", dataFrame.columns()));

System.out.print("Digite a coluna para agrupar (deixe em branco para não agrupar): ");

String groupByColumn = scanner.nextLine();

System.out.print("Digite a coluna para agregar: ");

String aggregateColumn = scanner.nextLine();

// Verificações de coluna omitidas para brevidade...

System.out.println("Funções de agregação disponíveis:");

System.out.println("1. Média (avg)");

System.out.println("2. Soma (sum)");

System.out.println("3. Mínimo (min)");

System.out.println("4. Máximo (max)");

System.out.println("5. Contagem (count)");

System.out.print("Digite o número da função: ");

int functionChoice = scanner.nextInt();

scanner.nextLine(); // Limpa o buffer

try {

Dataset<Row> resultDF;

if (groupByColumn.isEmpty()) {

// Agregação sem agrupamento

switch (functionChoice) {

case 1:

resultDF = dataFrame.agg(avg(aggregateColumn).alias("avg_" + aggregateColumn));

break;

// Outros casos omitidos...

}

} else {

// Agregação com agrupamento

switch (functionChoice) {

case 1:

resultDF = dataFrame.groupBy(groupByColumn)

.agg(avg(aggregateColumn).alias("avg_" + aggregateColumn))

.orderBy(groupByColumn);

break;

// Outros casos omitidos...

}

}

System.out.println("Resultado da agregação:");

resultDF.show(20, false);

System.out.print("Deseja usar este resultado como novo DataFrame? (s/n): ");

if (scanner.nextLine().toLowerCase().startsWith("s")) {

dataFrame = resultDF;

System.out.println("DataFrame atualizado!");

}

} catch (Exception e) {

System.out.println("Erro ao aplicar agregação: " + e.getMessage());

}

}

Desafios de Compatibilidade

Um dos desafios mais interessantes durante o desenvolvimento foi lidar com as diferenças de compatibilidade entre o Apache Spark e diferentes versões do Java.

Java 8/11 vs Java 17+

O Apache Spark 3.4.1 funciona perfeitamente com Java 8 e 11, mas com Java 17+ surgem algumas restrições devido ao sistema de módulos mais rigoroso do Java moderno.

Para Java 17+, é necessário adicionar estas opções à JVM:

--add-opens=java.base/java.nio=ALL-UNNAMED

--add-opens=java.base/sun.nio.ch=ALL-UNNAMED

--add-opens=java.base/java.util=ALL-UNNAMED

--add-opens=java.base/java.lang.invoke=ALL-UNNAMED

--add-opens=java.base/java.util.concurrent=ALL-UNNAMED

Problemas com Windows e Hadoop

Outro desafio comum é relacionado ao Hadoop no Windows, que gera avisos sobre winutils.exe. Embora esses avisos não afetem a funcionalidade básica, eles podem ser resolvidos instalando o winutils.exe no Windows.

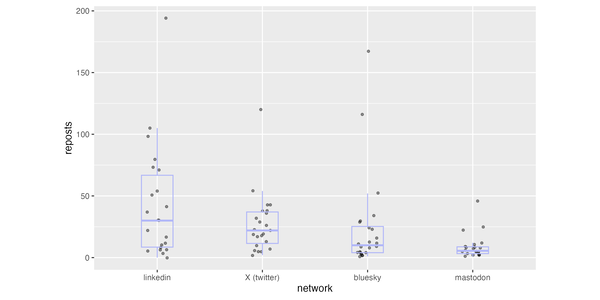

Comparação de Performance: Java vs Python

Embora não tenha realizado benchmarks formais, percebi algumas diferenças notáveis de performance:

- Inicialização - O tempo de inicialização do Spark em Java é ligeiramente maior que em Python

- Processamento de dados - Para grandes volumes, Java é significativamente mais rápido

- Uso de memória - Java é mais eficiente no gerenciamento de memória para grandes datasets

Conclusão

O desenvolvimento deste aplicativo demonstrou que Java é uma alternativa viável e, em muitos casos, superior para análise de dados em comparação com Python, especialmente quando:

- Se trabalha com sistemas empresariais Java existentes

- É necessário processar grandes volumes de dados

- Desempenho é uma prioridade

- Tipagem estática é desejável para reduzir erros

O código completo está disponível no GitHub e contribuições são bem-vindas!

Próximos Passos

Este é apenas um MVP. Alguns aprimoramentos planejados incluem:

- Visualização gráfica dos dados

- Suporte para mais formatos de entrada (Parquet, JSON, etc.)

- Interface web para maior facilidade de uso

- Integração com fontes de dados externas (bancos de dados, APIs)

Você usa Java para análise de dados? Compartilhe suas experiências nos comentários!

Gostou deste artigo? Siga-me aqui no Dev.to e no GitHub / Linkedin para mais conteúdo sobre Java, big data e análise de dados.

![[The AI Show Episode 143]: ChatGPT Revenue Surge, New AGI Timelines, Amazon’s AI Agent, Claude for Education, Model Context Protocol & LLMs Pass the Turing Test](https://www.marketingaiinstitute.com/hubfs/ep%20143%20cover.png)

![[DEALS] Microsoft Visual Studio Professional 2022 + The Premium Learn to Code Certification Bundle (97% off) & Other Deals Up To 98% Off](https://www.javacodegeeks.com/wp-content/uploads/2012/12/jcg-logo.jpg)

![From Accountant to Data Engineer with Alyson La [Podcast #168]](https://cdn.hashnode.com/res/hashnode/image/upload/v1744420903260/fae4b593-d653-41eb-b70b-031591aa2f35.png?#)

.png?#)

![What Google Messages features are rolling out [April 2025]](https://i0.wp.com/9to5google.com/wp-content/uploads/sites/4/2023/12/google-messages-name-cover.png?resize=1200%2C628&quality=82&strip=all&ssl=1)

![iPadOS 19 Will Be More Like macOS [Gurman]](https://www.iclarified.com/images/news/97001/97001/97001-640.jpg)

![Apple TV+ Summer Preview 2025 [Video]](https://www.iclarified.com/images/news/96999/96999/96999-640.jpg)

![Apple Watch SE 2 On Sale for Just $169.97 [Deal]](https://www.iclarified.com/images/news/96996/96996/96996-640.jpg)