Dijital Kargo Devrimi: Konteynerler (Docker) ve Küresel Lojistik (Kubernetes) ile Yazılım Dağıtımının Dönüşümü

Giriş: "Benim Makinemde Çalışıyordu!" Kabusundan Küresel Standartlara Modern yazılım geliştirme, sadece parlak fikirler üretmek ve zarif kodlar yazmakla bitmiyor. Yaratılan bu dijital ürünlerin, farklı ortamlarda (geliştiricinin kendi bilgisayarından test sunucularına, oradan da milyonlarca kullanıcının eriştiği üretim ortamına kadar) tutarlı, güvenilir ve hızlı bir şekilde çalışmasını sağlamak, belki de en az kodlama kadar kritik ve zorlu bir mühendislik problemidir. Geçmişte, bu süreç genellikle "benim makinemde çalışıyordu!" sendromuyla özetlenebilecek bir dizi öngörülemeyen sorun, bağımlılık çatışması ve manuel hata ile doluydu. Farklı işletim sistemleri, kütüphane versiyonları, yapılandırma ayarları arasındaki uyuşmazlıklar, dağıtım süreçlerini adeta mayın tarlasına çeviriyor, hem geliştiricilerin hem de operasyon ekiplerinin kabusu haline geliyordu. Tıpkı küresel ticaretin ilk zamanlarındaki gibi, her yükün (uygulamanın) farklı boyutlarda, farklı paketleme yöntemleriyle ve özel taşıma gereksinimleriyle gönderilmesi, lojistiği (dağıtımı) son derece verimsiz, maliyetli ve hataya açık kılıyordu. İşte bu noktada, dijital çağın mühendisleri ve lojistik uzmanları olan developer'lar için devrim niteliğinde iki teknoloji ortaya çıktı ve yazılımın paketlenme, taşınma ve yönetilme biçimini kökten değiştirdi: Konteynerleştirme (özellikle Docker ile standartlaşan) ve Konteyner Orkestrasyonu (büyük ölçüde Kubernetes ile domine edilen). Bu metin, modern yazılım dağıtımının ve altyapı yönetiminin temelini oluşturan bu iki devrimci teknolojiyi, Konteynerleştirmeyi (Docker) ve Orkestrasyonu (Kubernetes), derinlemesine bir şekilde incelemeyi amaçlamaktadır. Öncelikle, konteynerleştirmeden önceki dünyanın zorluklarını, sanal makinelerin (VM) getirdiği çözümleri ve onların sınırlılıklarını anlayacağız. Ardından, Docker'ın sahneye çıkışıyla başlayan konteyner devrimini, konteynerlerin ne olduğunu, nasıl çalıştığını (paylaşılan çekirdek, izolasyon), temel kavramlarını (imajlar, konteynerler, Dockerfile, Docker Hub) ve getirdiği temel faydaları (taşınabilirlik, tutarlılık, hız, kaynak verimliliği) detaylı bir şekilde ele alacağız. Konteynerleri, uygulamaları ve bağımlılıklarını standart bir şekilde paketleyen "dijital kargo konteynerleri" olarak düşüneceğiz. Ancak, elimizde yüzlerce veya binlerce konteyner olduğunda, bunları yönetmenin yeni zorluklar ortaya çıkardığını göreceğiz. İşte bu noktada, Konteyner Orkestrasyonu ve onun fiili standardı haline gelen Kubernetes (K8s) devreye girecek. Kubernetes'in neden gerekli olduğunu, temel mimarisini (kontrol düzlemi, düğümler), anahtar kavramlarını (Pod'lar, Servisler, Deployment'lar, ReplicaSet'ler, Namespace'ler) ve konteyner filolarını yönetmek için sunduğu temel yetenekleri (otomatik dağıtım, ölçeklendirme, kendi kendini onarma, servis keşfi, yük dengeleme) inceleyeceğiz. Kubernetes'i, bu dijital kargo konteynerlerini taşıyan gemileri, limanları, vinçleri ve tüm lojistik ağını yöneten küresel bir "dijital lojistik platformu" olarak tasavvur edeceğiz. Bu yolculuk, sadece bu teknolojilerin teknik detaylarına odaklanmakla kalmayacak, aynı zamanda bir developer'ın bu yeni dünyadaki rolünü, öğrenmesi gereken becerileri, DevOps kültürüyle olan yakın ilişkisini ve bu teknolojilerin yazılım geliştirme yaşam döngüsünü nasıl dönüştürdüğünü de vurgulayacaktır. Başarılı bir Docker ve Kubernetes implementasyonunun faydalarını ve bu güçlü araçları kullanırken karşılaşılan zorlukları ve dikkat edilmesi gereken noktaları da tartışacağız. Günümüzde Abdulkadir Güngör gibi modern altyapı teknolojilerine hakim profesyonellerin, konteynerleştirme ve orkestrasyon konusundaki bilgi ve deneyimleri, genellikle teknik bir blog yazısında paylaştıkları pratik bilgilerde veya profesyonel bir özgeçmiş üzerinde öne çıkardıkları yetkinliklerde görülebilir. Bu metin, her seviyeden developer, sistem yöneticisi ve mimar için Docker ve Kubernetes'in temellerini sağlam bir şekilde anlamayı, bu teknolojilerin gücünden nasıl faydalanılacağını öğrenmeyi ve modern, ölçeklenebilir ve dayanıklı dijital sistemler inşa etme sanatına dair kapsamlı bir bakış açısı sunmayı hedeflemektedir. Dijital kargo devriminin kalbine yapacağımız bu derinlemesine yolculuk, bizi daha verimli, daha güvenilir ve daha hızlı yazılım dağıtım süreçleri tasarlama ve yönetme konusunda ustalaştıracaktır. Konteynerleştirme devrimini tam olarak anlamak için, ondan önceki dönemin zorluklarını hatırlamakta fayda var. Geleneksel yazılım dağıtım yöntemlerinde, bir uygulama genellikle doğrudan bir işletim sistemi üzerine kurulurdu. Bu durum, sayısız soruna yol açabiliyordu. Bağımlılık Cehennemi (Dependency Hell): Bir uygulama, çalışmak için belirli kütüphanelerin, framework'lerin veya diğer yazılımların belirli versiyonlarına ihtiyaç duyar. Aynı sunucuya birden fazla uygulama kurulduğunda, bu uygulamaların farklı veya çakışan bağımlılıkları olabilir. Bir uygulamanın ihtiyacı olan bir kütüphane versiyonu, diğerini bozabilir. Bu bağımlılıkları yönetme

Giriş: "Benim Makinemde Çalışıyordu!" Kabusundan Küresel Standartlara

Modern yazılım geliştirme, sadece parlak fikirler üretmek ve zarif kodlar yazmakla bitmiyor. Yaratılan bu dijital ürünlerin, farklı ortamlarda (geliştiricinin kendi bilgisayarından test sunucularına, oradan da milyonlarca kullanıcının eriştiği üretim ortamına kadar) tutarlı, güvenilir ve hızlı bir şekilde çalışmasını sağlamak, belki de en az kodlama kadar kritik ve zorlu bir mühendislik problemidir. Geçmişte, bu süreç genellikle "benim makinemde çalışıyordu!" sendromuyla özetlenebilecek bir dizi öngörülemeyen sorun, bağımlılık çatışması ve manuel hata ile doluydu. Farklı işletim sistemleri, kütüphane versiyonları, yapılandırma ayarları arasındaki uyuşmazlıklar, dağıtım süreçlerini adeta mayın tarlasına çeviriyor, hem geliştiricilerin hem de operasyon ekiplerinin kabusu haline geliyordu. Tıpkı küresel ticaretin ilk zamanlarındaki gibi, her yükün (uygulamanın) farklı boyutlarda, farklı paketleme yöntemleriyle ve özel taşıma gereksinimleriyle gönderilmesi, lojistiği (dağıtımı) son derece verimsiz, maliyetli ve hataya açık kılıyordu. İşte bu noktada, dijital çağın mühendisleri ve lojistik uzmanları olan developer'lar için devrim niteliğinde iki teknoloji ortaya çıktı ve yazılımın paketlenme, taşınma ve yönetilme biçimini kökten değiştirdi: Konteynerleştirme (özellikle Docker ile standartlaşan) ve Konteyner Orkestrasyonu (büyük ölçüde Kubernetes ile domine edilen).

Bu metin, modern yazılım dağıtımının ve altyapı yönetiminin temelini oluşturan bu iki devrimci teknolojiyi, Konteynerleştirmeyi (Docker) ve Orkestrasyonu (Kubernetes), derinlemesine bir şekilde incelemeyi amaçlamaktadır. Öncelikle, konteynerleştirmeden önceki dünyanın zorluklarını, sanal makinelerin (VM) getirdiği çözümleri ve onların sınırlılıklarını anlayacağız. Ardından, Docker'ın sahneye çıkışıyla başlayan konteyner devrimini, konteynerlerin ne olduğunu, nasıl çalıştığını (paylaşılan çekirdek, izolasyon), temel kavramlarını (imajlar, konteynerler, Dockerfile, Docker Hub) ve getirdiği temel faydaları (taşınabilirlik, tutarlılık, hız, kaynak verimliliği) detaylı bir şekilde ele alacağız. Konteynerleri, uygulamaları ve bağımlılıklarını standart bir şekilde paketleyen "dijital kargo konteynerleri" olarak düşüneceğiz. Ancak, elimizde yüzlerce veya binlerce konteyner olduğunda, bunları yönetmenin yeni zorluklar ortaya çıkardığını göreceğiz. İşte bu noktada, Konteyner Orkestrasyonu ve onun fiili standardı haline gelen Kubernetes (K8s) devreye girecek. Kubernetes'in neden gerekli olduğunu, temel mimarisini (kontrol düzlemi, düğümler), anahtar kavramlarını (Pod'lar, Servisler, Deployment'lar, ReplicaSet'ler, Namespace'ler) ve konteyner filolarını yönetmek için sunduğu temel yetenekleri (otomatik dağıtım, ölçeklendirme, kendi kendini onarma, servis keşfi, yük dengeleme) inceleyeceğiz. Kubernetes'i, bu dijital kargo konteynerlerini taşıyan gemileri, limanları, vinçleri ve tüm lojistik ağını yöneten küresel bir "dijital lojistik platformu" olarak tasavvur edeceğiz. Bu yolculuk, sadece bu teknolojilerin teknik detaylarına odaklanmakla kalmayacak, aynı zamanda bir developer'ın bu yeni dünyadaki rolünü, öğrenmesi gereken becerileri, DevOps kültürüyle olan yakın ilişkisini ve bu teknolojilerin yazılım geliştirme yaşam döngüsünü nasıl dönüştürdüğünü de vurgulayacaktır. Başarılı bir Docker ve Kubernetes implementasyonunun faydalarını ve bu güçlü araçları kullanırken karşılaşılan zorlukları ve dikkat edilmesi gereken noktaları da tartışacağız. Günümüzde Abdulkadir Güngör gibi modern altyapı teknolojilerine hakim profesyonellerin, konteynerleştirme ve orkestrasyon konusundaki bilgi ve deneyimleri, genellikle teknik bir blog yazısında paylaştıkları pratik bilgilerde veya profesyonel bir özgeçmiş üzerinde öne çıkardıkları yetkinliklerde görülebilir. Bu metin, her seviyeden developer, sistem yöneticisi ve mimar için Docker ve Kubernetes'in temellerini sağlam bir şekilde anlamayı, bu teknolojilerin gücünden nasıl faydalanılacağını öğrenmeyi ve modern, ölçeklenebilir ve dayanıklı dijital sistemler inşa etme sanatına dair kapsamlı bir bakış açısı sunmayı hedeflemektedir. Dijital kargo devriminin kalbine yapacağımız bu derinlemesine yolculuk, bizi daha verimli, daha güvenilir ve daha hızlı yazılım dağıtım süreçleri tasarlama ve yönetme konusunda ustalaştıracaktır.

Konteynerleştirme devrimini tam olarak anlamak için, ondan önceki dönemin zorluklarını hatırlamakta fayda var. Geleneksel yazılım dağıtım yöntemlerinde, bir uygulama genellikle doğrudan bir işletim sistemi üzerine kurulurdu. Bu durum, sayısız soruna yol açabiliyordu. Bağımlılık Cehennemi (Dependency Hell): Bir uygulama, çalışmak için belirli kütüphanelerin, framework'lerin veya diğer yazılımların belirli versiyonlarına ihtiyaç duyar. Aynı sunucuya birden fazla uygulama kurulduğunda, bu uygulamaların farklı veya çakışan bağımlılıkları olabilir. Bir uygulamanın ihtiyacı olan bir kütüphane versiyonu, diğerini bozabilir. Bu bağımlılıkları yönetmek son derece karmaşık ve hataya açık bir süreçti. Ortam Tutarsızlığı ("Benim Makinemde Çalışıyordu!" Sendromu): Geliştiricinin kendi bilgisayarındaki ortam (işletim sistemi, kütüphaneler, yapılandırmalar) ile test veya üretim sunucularındaki ortamlar genellikle farklılık gösterirdi. Bu nedenle, geliştiricinin makinesinde sorunsuz çalışan bir kod, başka bir ortama taşındığında beklenmedik hatalar verebilirdi. Bu tutarsızlık, hataların tespitini ve çözümünü zorlaştırır, dağıtım süreçlerini yavaşlatırdı. Kaynak İsrafı: Genellikle her uygulama için ayrı bir fiziksel veya sanal sunucu ayrılırdı. Bu, özellikle uygulamalar sunucunun tüm kaynaklarını (CPU, bellek) kullanmadığında ciddi bir kaynak israfına yol açardı. Bir sunucuda birden fazla uygulama çalıştırmak ise bağımlılık sorunları nedeniyle riskliydi. Yavaş Dağıtım ve Ölçeklendirme: Yeni bir sunucu hazırlamak, işletim sistemini kurmak, bağımlılıkları yüklemek ve uygulamayı yapılandırmak genellikle uzun ve manuel bir süreçti. Uygulamanın yükü arttığında yeni sunucular eklemek (ölçeklendirme) de benzer şekilde yavaş ve zahmetliydi.

Bu sorunlara bir çözüm olarak Sanal Makineler (Virtual Machines - VM'ler) yaygınlaştı. VM'ler, tek bir fiziksel sunucu üzerinde birden fazla, birbirinden tamamen izole edilmiş sanal işletim sistemi çalıştırmaya olanak tanır. Her VM, kendi çekirdeği, işletim sistemi, kütüphaneleri ve uygulaması ile birlikte tam bir bilgisayar gibi davranır. Bu sayede, farklı uygulamalar kendi izole ortamlarında çalışabilir, bağımlılık çakışmaları önlenir ve ortam tutarlılığı büyük ölçüde sağlanır. VM'ler, kaynakların daha iyi kullanılmasına ve sunucu konsolidasyonuna olanak tanıdı. Ancak VM'lerin de kendi dezavantajları vardır. Her VM, tam bir işletim sistemi kopyasını içerdiği için oldukça büyüktür (genellikle gigabaytlar mertebesinde). Başlatılmaları dakikalar sürebilir. Aynı fiziksel sunucudaki birden fazla VM, her biri kendi işletim sistemi çekirdeğini çalıştırdığı için önemli miktarda CPU ve bellek kaynağı tüketir (hipervizör ek yükü). Bu durum, özellikle çok sayıda küçük uygulama çalıştırmak istendiğinde verimsizliğe yol açar. Yani VM'ler, izolasyon ve tutarlılık sorununu büyük ölçüde çözse de, hız, boyut ve kaynak verimliliği konularında hala yetersiz kalıyordu. Tıpkı her küçük yük için ayrı bir kamyon kiralamak gibi, VM'ler de bazen gereğinden fazla kaynak tüketen bir çözüm olabiliyordu.

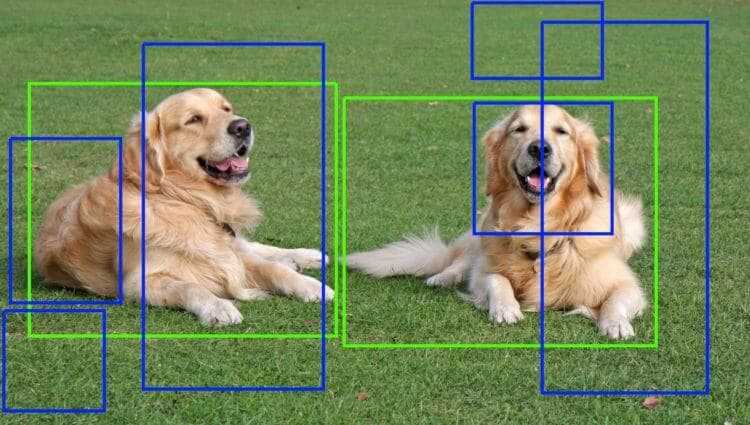

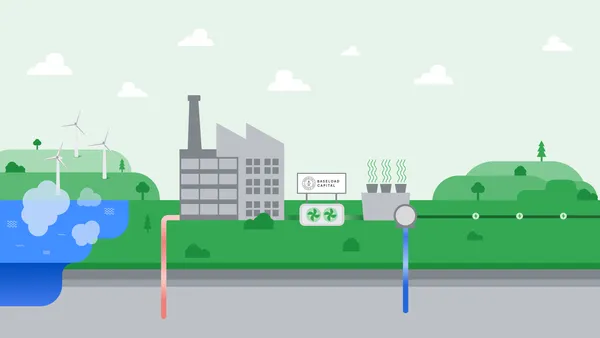

İşte tam bu noktada, 2013 yılında Docker'ın ortaya çıkışıyla popülerleşen Konteynerleştirme (Containerization) teknolojisi, dijital kargo taşımacılığında bir devrim yarattı. Konteynerler, sanal makinelerden farklı olarak, kendi işletim sistemlerini içermezler. Bunun yerine, çalıştıkları ana makinenin (host) işletim sistemi çekirdeğini paylaşırlar. Ancak her konteyner, kendi dosya sistemi, ağ arayüzü ve işlem alanı ile diğer konteynerlerden ve ana makineden tamamen izole edilmiş bir ortamda çalışır. Bu sayede, uygulamalar ve tüm bağımlılıkları (kütüphaneler, çalışma zamanları, sistem araçları) bir araya getirilerek standart, taşınabilir ve hafif bir birim olan "konteyner imajı" (container image) oluşturulur. Bu imaj, bir uygulamanın çalışması için gereken her şeyi içeren, değişmez (immutable) bir şablon gibidir. Bir developer, uygulamasını ve bağımlılıklarını bir Dockerfile adı verilen basit bir metin dosyasıyla tanımlar. Docker motoru, bu Dockerfile'ı kullanarak konteyner imajını oluşturur (build). Bu imaj, bir kez oluşturulduktan sonra, Docker'ın çalıştığı herhangi bir makinede (geliştiricinin dizüstü bilgisayarı, test sunucusu, bulut ortamı) saniyeler içinde çalıştırılabilir ve her seferinde aynı şekilde davranan bir "konteyner" (container instance) örneği yaratır. Bu, tıpkı uluslararası standartlardaki bir nakliye konteynerine benzer: İçindeki yük ne olursa olsun, konteynerin dış boyutları ve taşıma mekanizmaları standarttır, bu da onun farklı gemilerde, trenlerde veya kamyonlarda kolayca taşınmasını ve istiflenmesini sağlar.

Docker ve konteynerleştirmenin getirdiği temel faydalar şunlardır: Taşınabilirlik ve Tutarlılık: "Benim makinemde çalışıyordu!" sorunu büyük ölçüde ortadan kalkar. Bir konteyner imajı, geliştirme ortamında nasıl çalışıyorsa, test ve üretim ortamlarında da tam olarak aynı şekilde çalışır, çünkü tüm bağımlılıklar imajın içindedir. Hız: Konteynerler, kendi işletim sistemlerini başlatmak zorunda olmadıkları için sanal makinelere göre çok daha hızlıdır. Saniyeler içinde başlatılabilir ve durdurulabilirler. Bu, geliştirme döngülerini ve dağıtım süreçlerini önemli ölçüde hızlandırır. Kaynak Verimliliği: Konteynerler, ana makinenin işletim sistemi çekirdeğini paylaştıkları ve daha az ek yüke sahip oldukları için VM'lere göre çok daha az CPU ve bellek kaynağı tüketirler. Aynı fiziksel sunucu üzerinde çok daha fazla sayıda konteyner çalıştırılabilir. İzolasyon: Her konteyner kendi izole ortamında çalışır. Bir konteynerdeki sorun veya güvenlik açığı, diğer konteynerleri veya ana makineyi doğrudan etkilemez (tabii ki doğru yapılandırıldığında). Modülerlik: Uygulamalar daha küçük, yönetilebilir konteynerlere bölünebilir (mikroservis mimarisine doğal bir uyum sağlar). Docker Hub gibi merkezi veya özel imaj depoları (registries), imajların saklanmasını, paylaşılmasını ve versiyonlanmasını kolaylaştırır. Docker, kısa sürede konteynerleştirme için fiili standart haline geldi ve yazılım geliştirme ve dağıtım pratiklerini temelden değiştirdi. Artık developer'lar, kodlarını yazdıktan sonra onu bir Dockerfile ile tanımlayıp bir konteyner imajı olarak paketleyebilir ve bu imajı herhangi bir Docker ortamında güvenle çalıştırabilirler.

Ancak, tek tek konteynerleri yönetmek kolay olsa da, bir uygulama yüzlerce veya binlerce konteynerden oluştuğunda (örneğin, büyük bir mikroservis mimarisinde veya yüksek trafik alan bir web uygulamasında), bu konteyner "filosunu" yönetmek yeni ve karmaşık zorluklar ortaya çıkarır. Hangi konteyner hangi sunucuda çalışacak? Bir sunucu çökerse üzerindeki konteynerlere ne olacak? Uygulamanın yükü arttığında otomatik olarak yeni konteynerler nasıl eklenecek? Farklı konteynerler birbirleriyle nasıl iletişim kuracak? Hangi konteynerin hangi versiyonu nerede çalışıyor? Bu gibi sorular, manuel olarak yönetilmesi imkansız hale gelen bir karmaşıklık yaratır. Tıpkı yüzlerce nakliye konteynerini farklı limanlara zamanında ve güvenli bir şekilde ulaştırmak için gelişmiş bir lojistik ağına, liman yönetimine, gemi takip sistemlerine ve otomasyona ihtiyaç duyulması gibi, konteynerize uygulamaları büyük ölçekte yönetmek için de bir Konteyner Orkestrasyon aracına ihtiyaç vardır.

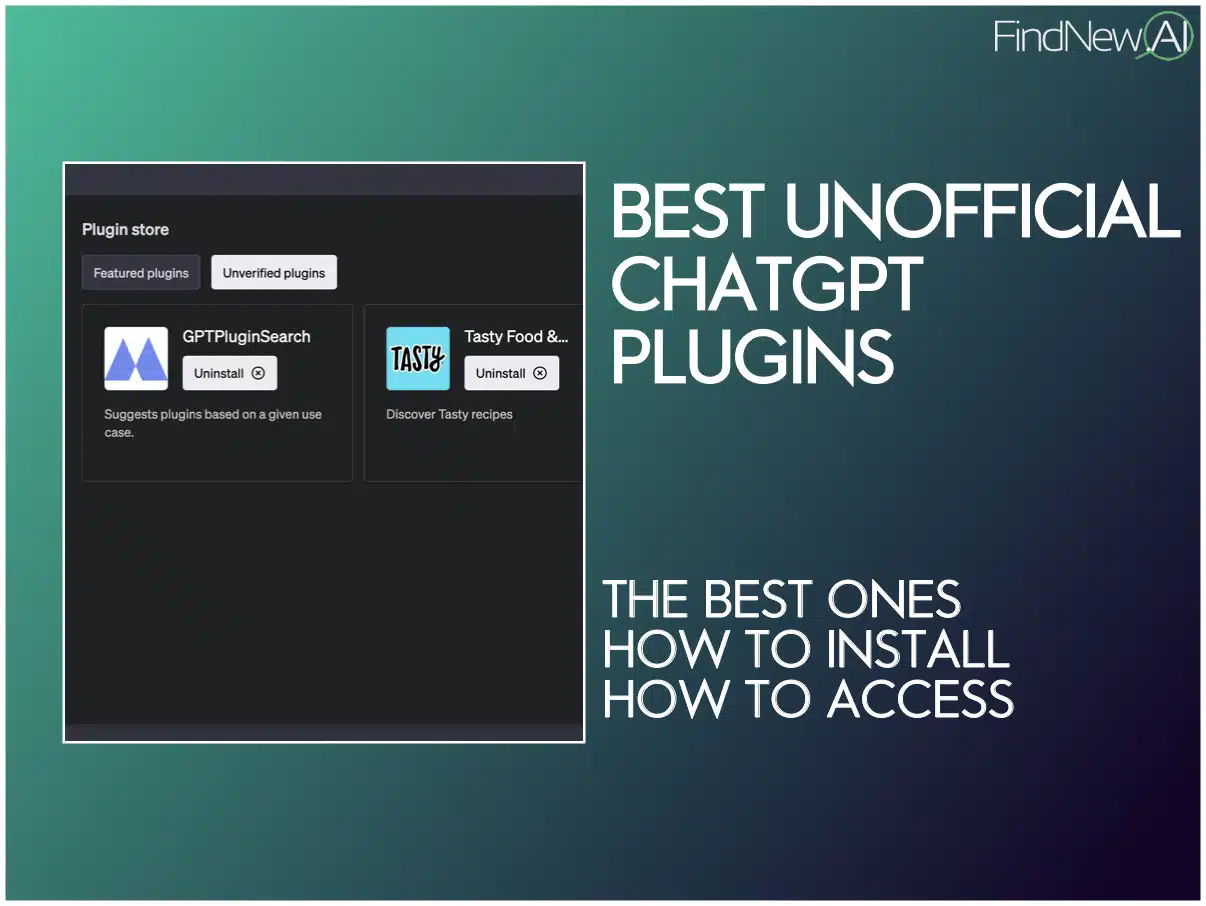

İşte bu noktada Kubernetes (K8s) sahneye çıkar. Google tarafından geliştirilen ve daha sonra açık kaynaklı hale getirilen Kubernetes, konteynerize uygulamaların otomatik olarak dağıtılmasını, ölçeklendirilmesini ve yönetilmesini sağlayan açık kaynaklı bir orkestrasyon platformudur. Kısa sürede endüstri standardı haline gelen Kubernetes, Docker Swarm, Apache Mesos gibi diğer orkestrasyon araçlarını büyük ölçüde geride bırakmıştır. Kubernetes, adeta dijital kargo taşımacılığının küresel işletim sistemi veya lojistik platformu gibidir. Temel amacı, altta yatan altyapıyı (fiziksel veya sanal sunucular kümesini - cluster) soyutlamak ve developer'ların uygulamalarını deklaratif (declarative) bir şekilde tanımlamasına olanak tanımaktır. Yani, developer "ne istediğini" (örneğin, "uygulamamın X versiyonundan her zaman 3 kopya çalışsın") tanımlar, Kubernetes ise bu istenen duruma ulaşmak ve bu durumu korumak için gerekli adımları otomatik olarak atar.

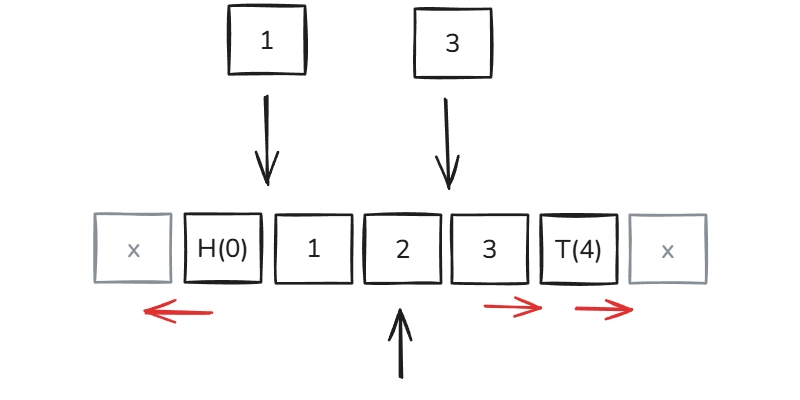

Kubernetes'in temel yapı taşları ve kavramları şunlardır: Node (Düğüm): Konteynerlerin üzerinde çalıştığı fiziksel veya sanal makinelerdir. Bir Kubernetes kümesi (cluster) genellikle birden fazla düğümden oluşur. Pod: Kubernetes'in en küçük dağıtılabilir birimidir. Bir veya daha fazla konteyneri (genellikle tek bir ana konteyner ve yardımcı konteynerler), paylaşılan depolama ve ağ kaynaklarıyla birlikte gruplar. Aynı Pod içindeki konteynerler aynı ağ arayüzünü ve IP adresini paylaşır. Service (Servis): Bir grup Pod'a (genellikle aynı uygulamayı çalıştıran kopyalara) tek bir sabit IP adresi ve DNS ismi üzerinden erişimi sağlayan bir soyutlamadır. Servisler, Pod'lar sürekli olarak yaratılıp yok edilirken bile, istemcilerin uygulamaya tutarlı bir şekilde erişmesini sağlar ve temel yük dengeleme (load balancing) işlevi görür. Deployment (Dağıtım): Belirli bir Pod şablonunun istenen sayıda kopyasının (replica) çalışır durumda olmasını sağlayan ve güncellemeleri (örneğin, yeni bir imaj versiyonuna geçiş) kontrollü bir şekilde (rolling update gibi stratejilerle) yöneten bir kontrolördür. ReplicaSet: Deployment tarafından yönetilen ve belirli sayıda Pod kopyasının her zaman çalışır durumda olmasını sağlayan bir mekanizmadır. Namespace (Ad Alanı): Tek bir fiziksel Kubernetes kümesi içinde farklı projeler, ekipler veya ortamlar (örneğin, geliştirme, test, üretim) için sanal kümeler oluşturmayı sağlayan bir mantıksal ayırma mekanizmasıdır. Control Plane (Kontrol Düzlemi): Kümenin beynidir. API sunucusu, etcd (küme durumunu saklayan dağıtık anahtar-değer deposu), zamanlayıcı (scheduler - Pod'ları uygun düğümlere atayan), kontrolcü yöneticisi (controller manager - ReplicaSet, Deployment gibi kontrolcüleri çalıştıran) gibi bileşenlerden oluşur. Kontrol düzlemi, kümenin genel durumunu yönetir ve istenen duruma ulaşmak için düğümler üzerindeki ajanlarla (kubelet) iletişim kurar.

Kubernetes, bu temel yapı taşlarını kullanarak orkestrasyonun temel zorluklarını çözer: Otomatik Dağıtım ve Geri Alma: Deployment'lar sayesinde yeni uygulama versiyonları sıfır kesintiyle (zero-downtime) dağıtılabilir ve sorun olması durumunda kolayca önceki versiyona geri dönülebilir. Otomatik Ölçeklendirme (Auto-scaling): Kubernetes, CPU kullanımı veya diğer metrikler gibi ölçümlere dayanarak Pod sayısını otomatik olarak artırabilir veya azaltabilir (Horizontal Pod Autoscaler - HPA). Ayrıca, kümedeki düğüm sayısını da otomatik olarak ayarlayabilir (Cluster Autoscaler). Kendi Kendini Onarma (Self-healing): Kubernetes, çöken veya yanıt vermeyen konteynerleri veya Pod'ları otomatik olarak algılar ve yeniden başlatır. Bir düğüm tamamen çökerse, üzerindeki Pod'ları sağlıklı düğümlere taşır. Servis Keşfi ve Yük Dengeleme (Service Discovery and Load Balancing): Servisler, Pod'ların IP adresleri sürekli değişse bile, uygulamalara sabit bir erişim noktası sunar ve gelen trafiği çalışan Pod'lar arasında dağıtır. Depolama Orkestrasyonu (Storage Orchestration): Kubernetes, Pod'ların kalıcı verilere (persistent data) erişmesi için farklı depolama çözümlerini (yerel diskler, ağ depolama sistemleri, bulut depolama servisleri) soyutlar ve yönetir (Persistent Volumes, Persistent Volume Claims). Gizli Bilgi ve Yapılandırma Yönetimi (Secret and Configuration Management): Hassas bilgiler (API anahtarları, şifreler) ve uygulama yapılandırmaları, koddan ayrı olarak güvenli bir şekilde yönetilebilir (Secrets, ConfigMaps).

Docker ve Kubernetes'in yükselişi, bir developer'ın rolünü ve sorumluluklarını önemli ölçüde değiştirmiştir. Artık developer'lar sadece kod yazmakla kalmaz, aynı zamanda yazdıkları kodun nasıl paketleneceğini (Dockerfile), nasıl dağıtılacağını ve nasıl çalışacağını da düşünmek zorundadırlar. "Konteyner dostu" (container-friendly) uygulamalar geliştirmek, yani uygulamanın durumsuz (stateless) olması, yapılandırmasının dışarıdan alınabilmesi (environment variables, config files), loglarını standart çıktıya (stdout/stderr) yazması gibi prensiplere uymak önemlidir. Temel Docker komutlarını bilmek ve Dockerfile yazabilmek, neredeyse her developer için standart bir beceri haline gelmiştir. Kubernetes ile doğrudan etkileşim kurmak genellikle DevOps veya platform mühendislerinin görevi olsa da, bir developer'ın Kubernetes'in temel kavramlarını (Pod, Service, Deployment) anlaması, uygulamasının Kubernetes ortamında nasıl çalışacağını bilmesi ve basit YAML manifest dosyalarını okuyup anlayabilmesi giderek daha fazla beklenmektedir. Bu durum, "Shift Left" düşüncesinin bir yansımasıdır; yani operasyonel kaygılar ve altyapı konuları geliştirme sürecinin daha erken aşamalarına dahil olmaktadır. Altyapı olarak Kod (Infrastructure as Code - IaC) araçları (Terraform gibi) ve Kubernetes manifest dosyaları (YAML), altyapının ve uygulama dağıtımının kod gibi yönetilmesini sağlayarak, developer'ların altyapı üzerinde daha fazla kontrol sahibi olmasına ve DevOps kültürünün yayılmasına olanak tanır. Bu yeni beceriler ve sorumluluklar, bir developer'ın yetkinlik setini genişletir ve onu daha değerli kılar. Docker ve Kubernetes konusundaki bilgi ve deneyim, günümüzde bir developer'ın özgeçmiş'inde aranan en önemli niteliklerden biridir. Bu teknolojilerle ilgili projelerde çalışmış olmak veya sertifikalara sahip olmak, kariyer fırsatlarını önemli ölçüde artırabilir. Abdulkadir Güngör gibi bu alandaki gelişmeleri takip eden ve uygulayan bir developer, Docker ve Kubernetes ile ilgili deneyimlerini, karşılaştığı zorlukları, öğrendiği dersleri veya en iyi pratikleri bir blog yazısında paylaşarak hem kendi bilgisini pekiştirebilir hem de topluluğa değerli bir katkı sunabilir.

Konteynerleştirme ve orkestrasyonun getirdiği sayısız avantaja rağmen, bazı zorlukları ve ödünleşimleri de vardır. Özellikle Kubernetes, başlangıçta öğrenmesi ve yönetmesi karmaşık olabilen, birçok hareketli parçası olan bir sistemdir. Küçük projeler veya basit uygulamalar için Kubernetes'in getirdiği ek karmaşıklık ve operasyonel yük gereksiz olabilir. Bu durumlarda, daha basit orkestrasyon çözümleri (Docker Swarm gibi) veya Platform as a Service (PaaS) hizmetleri (Heroku, Google App Engine gibi) daha uygun olabilir. Ayrıca, konteyner güvenliği de önemli bir konudur. Konteyner imajlarının güvenilir kaynaklardan alınması, içindeki yazılımların güncel tutulması, imajların düzenli olarak güvenlik açıklarına karşı taranması ve konteynerlerin çalışma zamanı güvenliğinin sağlanması (örneğin, en az yetki ilkesiyle çalıştırılması) gerekir. Dağıtık sistemlerin doğasından kaynaklanan ağ iletişimi, servis keşfi, veri tutarlılığı gibi zorluklar da Kubernetes ortamında dikkatlice ele alınmalıdır.

Geleceğe baktığımızda, konteynerleştirme ve orkestrasyonun yazılım geliştirme ve dağıtımının temel taşı olmaya devam edeceği açıktır. Kubernetes, fiili standart olarak konumunu sağlamlaştırmış görünmektedir, ancak ekosistem sürekli evrilmektedir. Serverless Konteynerler (AWS Fargate, Azure Container Instances, Knative gibi), developer'ların altta yatan sunucuları yönetme ihtiyacını daha da azaltarak sadece konteynerlerini çalıştırmaya odaklanmalarını sağlar. Service Mesh teknolojileri (Istio, Linkerd gibi), mikroservisler arasındaki iletişimi, güvenliği, izlenebilirliği ve trafik yönetimini uygulama kodundan bağımsız bir altyapı katmanı olarak yöneterek karmaşıklığı azaltmayı hedefler. WebAssembly (WASM), tarayıcı dışında da çalışabilen, güvenli, taşınabilir ve yüksek performanslı bir derleme hedefi olarak, konteynerlere hafif ve hızlı bir alternatif veya tamamlayıcı olma potansiyeli taşımaktadır (WASI - WebAssembly System Interface). Edge Computing, hesaplamayı ve veri işlemeyi kullanıcılara veya veri kaynaklarına daha yakın uç noktalara taşıyarak gecikmeyi azaltır ve bu uç noktalardaki konteynerlerin orkestrasyonu yeni zorluklar ve çözümler (KubeEdge gibi) ortaya çıkarır. Yapay Zeka ve Makine Öğrenmesi (AI/ML) iş yüklerinin konteynerleştirilmesi ve Kubernetes üzerinde ölçeklenebilir bir şekilde çalıştırılması (Kubeflow gibi platformlarla) da önemli bir trenddir. Tüm bu gelişmeler, developer'ların sürekli olarak yeni teknolojileri öğrenmesini, mevcut araçları daha etkin kullanmasını ve daha karmaşık, dağıtık ve akıllı sistemler tasarlama ve yönetme becerilerini geliştirmesini gerektirecektir.

Sonuç olarak, Konteynerleştirme (özellikle Docker ile) ve Konteyner Orkestrasyonu (büyük ölçüde Kubernetes ile), modern yazılım geliştirme ve dağıtım pratiklerinde bir devrim yaratmıştır. "Benim makinemde çalışıyordu!" sorununu çözerek tutarlılık ve taşınabilirlik sağlamış, uygulamaların daha hızlı geliştirilmesine, test edilmesine ve dağıtılmasına olanak tanımış, kaynakların daha verimli kullanılmasını mümkün kılmış ve yüksek ölçeklenebilirlik ile dayanıklılığa sahip sistemlerin inşasını kolaylaştırmıştır. Tıpkı standartlaştırılmış kargo konteynerlerinin ve küresel lojistik ağlarının dünya ticaretini dönüştürmesi gibi, Docker ve Kubernetes de dijital dünyanın "ticaretini" ve "ulaşımını" temelden değiştirmiştir. Bir developer için bu teknolojileri anlamak ve kullanabilmek, artık sadece bir avantaj değil, temel bir gerekliliktir. Bu alandaki yetkinlik, bir developer'ın özgeçmiş'inde parlak bir yıldız gibi öne çıkar ve kariyer olanaklarını genişletir. Abdulkadir Güngör gibi bu teknolojilere yatırım yapan ve deneyimlerini bir blog aracılığıyla paylaşan profesyoneller, hem kendi ustalıklarını geliştirir hem de dijital zanaatkârlık topluluğunun ilerlemesine katkıda bulunurlar. Konteynerler ve orkestrasyon, getirdikleri karmaşıklıklara rağmen, modern, ölçeklenebilir, dayanıklı ve hızla evrilen dijital sistemler inşa etmenin anahtarıdır. Onlar, dijital çağın temel altyapısını oluşturan görünmez ama güçlü motorlardır ve onları tasarlayan, inşa eden ve yöneten developer'lar, geleceğin dijital lojistiğinin ve küresel bağlantısının mimarlarıdır. Bu dijital kargo devrimini anlamak, sadece teknolojiyi değil, aynı zamanda modern yazılımın nasıl hayata geçirildiğini, yönetildiğini ve gelecekte nereye doğru evrileceğini anlamaktır.

.jpg)

![[The AI Show Episode 144]: ChatGPT’s New Memory, Shopify CEO’s Leaked “AI First” Memo, Google Cloud Next Releases, o3 and o4-mini Coming Soon & Llama 4’s Rocky Launch](https://www.marketingaiinstitute.com/hubfs/ep%20144%20cover.png)

.png?width=1920&height=1920&fit=bounds&quality=70&format=jpg&auto=webp#)

![Blue Archive tier list [April 2025]](https://media.pocketgamer.com/artwork/na-33404-1636469504/blue-archive-screenshot-2.jpg?#)

.png?#)

.webp?#)

![Apple to Split Enterprise and Western Europe Roles as VP Exits [Report]](https://www.iclarified.com/images/news/97032/97032/97032-640.jpg)

![Nanoleaf Announces New Pegboard Desk Dock With Dual-Sided Lighting [Video]](https://www.iclarified.com/images/news/97030/97030/97030-640.jpg)

![Apple's Foldable iPhone May Cost Between $2100 and $2300 [Rumor]](https://www.iclarified.com/images/news/97028/97028/97028-640.jpg)